こんにちは!DMMデータサイエンスグループの土屋です。本記事では先日データサイエンスグループのレコメンドチームで参加したRecSys2024の参加記録を共有します。

RecSysの概要

RecSys(ACM Conference on Recommender Systems)は、レコメンドシステムに関する最先端の研究や技術を発表する世界的に著名な国際会議です。レコメンドアルゴリズム、パーソナライズ技術など、レコメンド技術に関する幅広い分野の専門家が集まり、最新の成果やアイデアを共有します。大手テクノロジー企業からの参加者も多く、企業が抱える課題や実践的なアプローチを知る場ともなっています。研究論文の発表やワークショップ、ポスターセッション、チュートリアルが行われ、業界と学術の最新トレンドを知ることができます。今年はイタリアバーリで開催され、DMMレコメンドチームから土屋と寺井の2名が参加しました。

印象に残ったセッションと発表

本パートでは土屋と寺井の両名からそれぞれ気になった論文をご紹介します。

土屋パート

Biased User History Synthesis for Personalized Long-Tail Item Recommendation

論文URL: https://dl.acm.org/doi/10.1145/3640457.3688141

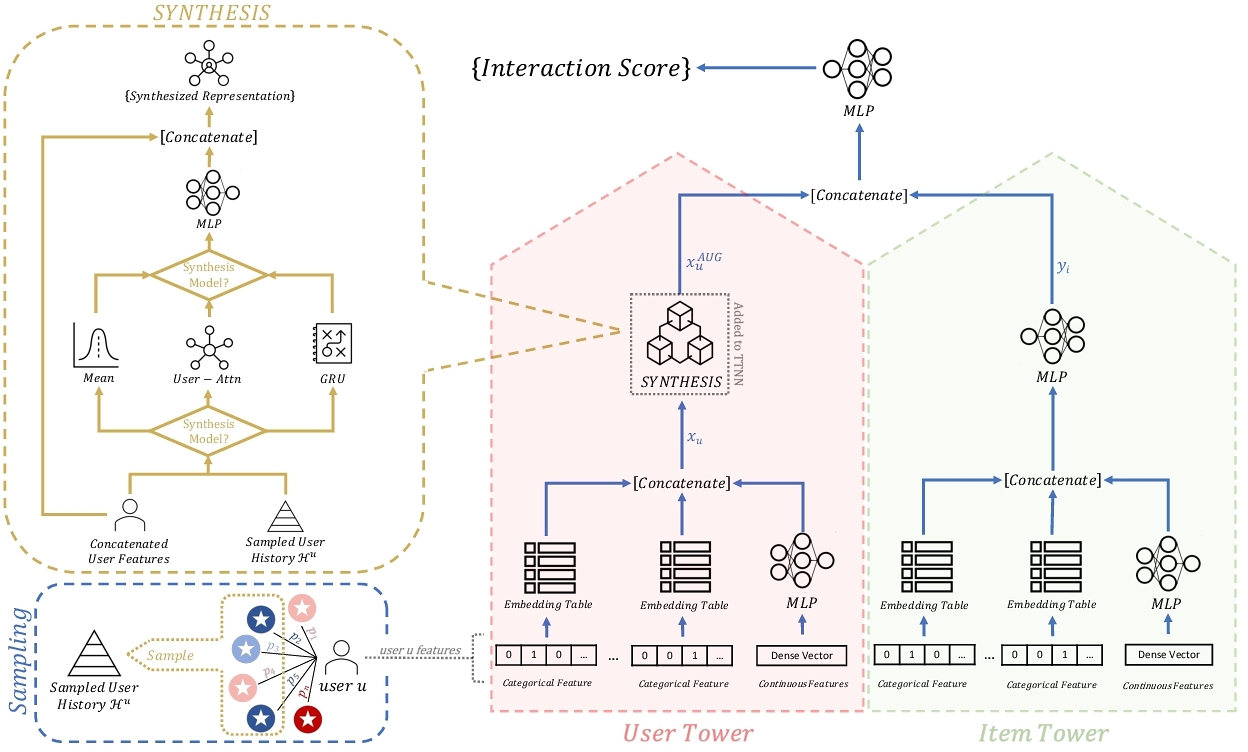

ユーザ行動を基にしたレコメンドでは新商品や不人気商品は履歴が少なく、バイアスの原因となります。本論文では行動履歴の少ないロングテール作品の行動履歴をサンプリングして合成することで、ロングテールに起因するモデルのバイアスをなくし、レコメンド精度の向上をした論文になります。具体的にはロングテール作品のユーザ履歴をサンプリングし、合成モデルを使用することで、ロングテール作品から効率的に情報を学習し精度の向上をできます。

合成モデルとはユーザ表現とサンプリングされたロングテールアイテムのリストをそれぞれ下記の三つのユニットを通して合成することでロングテールから合成したユーザ表現を獲得するモデルになります。

- MeanSynthesis: サンプリングしたアイテムのエンべディングの平均とユーザ表現からアイテムを同列に扱ったベクトルを獲得するユニット

- User-AttnSynthesis: サンプリングしたアイテムのエンべディングとユーザのAttentionからアイテムごとに重み付けした表現を獲得するユニット

- GRUSynthesis: 時系列を加味したGRUユニットを利用することで時間的な表現を獲得するユニット

DMMでは多くの商品を扱っているため、しばしば履歴の少ないロングテール作品の扱いについて問題になります。本論文の技術を使うことで日の目を浴びていない作品を精度よく学習に活用できるのではないかと興味を持ちました。

A Multi-modal Modeling Framework for Cold-start Short-video Recommendation

論文URL: https://dl.acm.org/doi/abs/10.1145/3640457.3688098

本論文の目的はショート動画のレコメンドにおけるコールドスタート問題の解消です。そのためにマルチモーダルモデリングフレームワークであるM3CSR(Multi-Modal Modeling framework for Cold-Start short video Recommendation)を提案しています。

マルチモーダルエンべディングでは学習済みの埋め込みが利用されますが、実際のユーザ行動とマルチモーダルのエンべディングには乖離が存在します。そこでtrainableなクラスタIDを利用することでオンラインでもユーザ行動を反映したマルチモーダルエンべディングを利用できるようになるM3CSRが提案されています。

具体的にはアイテムのマルチモーダルなデータからそれぞれ学習可能なクラスタIDを取得し、各モーダルのエンべディングと組み合わせてエンべディングを生成することで、マルチモーダルなデータから得られる表現とユーザ行動から得られる表現を一致させることができます。

また、マルチモーダルなデータごとにペアワイズロスをとって学習を進めることでマルチモーダルデータに対するユーザの興味の強弱を表現できるようにしています。

感想

DMMではショート動画の利用はありませんが、マルチモーダルデータの利用やオンライン推論などの取り組みを進めています。その中で本論文のコールドスタートに対する取り組みが非常に面白いと思い興味を持ちました。

寺井パート

Joint Modeling of Search and Recommendations Via an Unified Contextual Recommender (UniCoRn)

論文URL: https://dl.acm.org/doi/10.1145/3640457.3688034

Netflixにおいて、検索とレコメンドのタスクを一つのモデルで解くようにしたという論文です。

実世界のアプリケーションでは、検索とレコメンドのモデルをそれぞれ運用していることがほとんどですが、一つのモデルへ統合することにより、運用コストを下げつつ、それぞれのタスクにおいても性能向上を実現できたそうです。

感想

運用コストの観点に注目しており、産業界ならではの着眼点で面白かったです。DMMでも、まさに検索とレコメンドをそれぞれ運用しているので、統合できれば運用コストも下がり、コアな業務により注力できるのではと思いました。

Touch the Core: Exploring Task Dependence Among Hybrid Targets for Recommendation

論文URL: https://dl.acm.org/doi/10.1145/3640457.3688101

マルチタスク学習における分類タスクと回帰タスクを組み合わせたレコメンドシステムの課題を解決するためのフレームワークを提案した論文です。

マルチタスクなレコメンドシステムにおいて、クリックや購入といった離散値をとる目的変数 (分類タスク) と購入金額や視聴時間といった連続値をとる目的変数 (回帰タスク) の組み合わせが多く見られます。しかし、以下の2つが課題としてありました。

- 複数の目的変数間の依存関係を捉えることが難しい

- 最適化が難しい

本論文では、HTLNet (Hybrid Targets Learning Network) というフレームワークを提案し、上記の課題を解決しています。

1つ目の"複数の目的変数間の依存関係を捉えることが難しい"という課題については、上記フレームワーク内に下記2つの構造を導入することで、タスク間での予測情報を共有し適応的に情報を転送します。

- LEU(Label Embedding Unit)

- IFU(Information Fusion Unit)

2つ目の"最適化が難しい"という課題については、各タスクの勾配を調整し動的に重み付けをすることで全体の最適化が安定するような最適化戦略をとります。

提案手法の評価として、3つのデータセットによるオフライン実験と、オンラインファンドにおけるオンライン実験をしています。特にオンライン実験では、CTR、 CVR、 購入金額の利益がそれぞれ+0.54%、+1.4%、 +2.69%と向上したそうです。

感想

コアなKPIは連続値をとることが多いため、連続値の目的変数を含めつつ、ユーザー行動データのような離散値の目的変数も同時に学習する工夫が参考になりました。また、分類タスクと回帰タスクのマルチタスク学習に伴う課題についても知ることができ、勉強になりました。

現地の様子

RecSys2024はイタリアのバーリで開催されました。現地はからっとしていて温暖な気候でとても過ごしやすく綺麗な街並みでした。

おわりに

今回、レコメンドチームから2名、レコメンドシステムに関する国際学会RecSysに参加しました。

DMMサービス内では様々な形でレコメンドをユーザに提供しています。今回の学会を通して、社内では利用できていない技術や昨今話題になっている技術のレコメンド応用など、様々な角度でレコメンド技術についての議論がされており、今後のプロダクト改善の参考になりました。

DMMにあるデータは多岐に渡りますが、現状全てを余すことなく利用できていないことが現状です。その中で、本学会を通して様々な技術に触れ、新しいデータ活用方法について思考をめぐらせることができました。

本学会で得た知見や技術を今後、DMM内のサービスに活用し、さらなるUXの向上に努めたいと思います。

最後に、DMM データサイエンスグループでは一緒に働いてくれる仲間を募集しています!ご興味のある方は、ぜひ下記の募集ページをご確認ください!